介紹

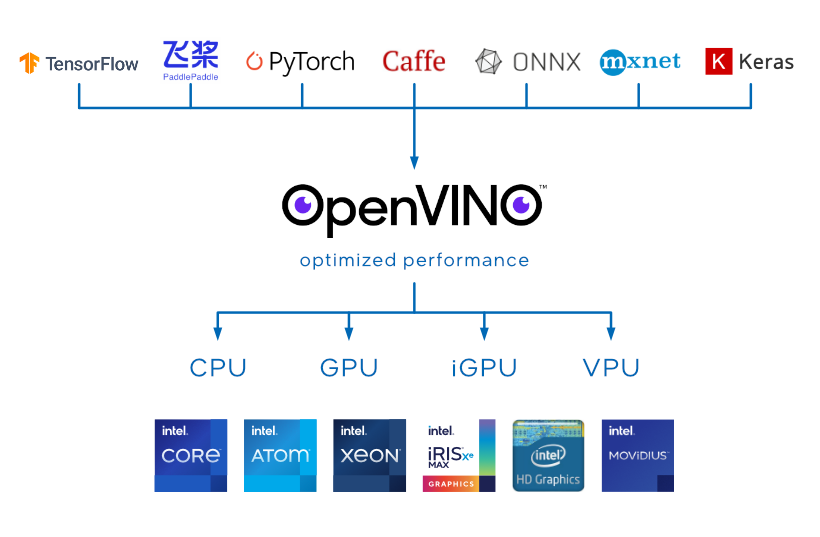

英特爾® Distribution of OpenVINO™ 工具套件是一個全面的工具套件,用於快速開發應用程序和解決方案,以解決各種任務,包括人類視覺仿真、自動語音識別、自然語言處理、推薦系統等。該工具包基於最新一代的人工神經網絡,包括卷積神經網絡 (CNN)、循環和基於注意力的網絡,將計算機視覺和非視覺工作負載擴展到英特爾® 硬件,最大限度地提高性能。它通過從邊緣部署到雲端的高性能、人工智能和深度學習推理來加速應用程序。

英特爾® Distribution of OpenVINO™ 工具套件:

- 實現從邊緣到雲端的深度學習推理。

- 支持跨英特爾加速器的異構執行,使用英特爾® CPU、英特爾® 集成顯卡、英特爾® 離散顯卡、 英特爾® 高斯和神經加速器、英特爾® 神經計算棒 2、英特爾® 視覺加速器設計與英特爾® Movidius的通用 API ™ VPU。

- 允許通過應用特殊方法來優化深度學習模型的推理,而無需模型重新訓練或微調,例如訓練後量化。

- 通過易於使用的 CV 函數庫和預優化內核加快上市時間。

- 包括對 CV 標準的優化調用,包括 OpenCV*(可單獨下載)和 OpenCL™。

第 1 版中的新增內容和更改內容

主要功能和改進摘要

此版本是 3.5 年來最大的升級!閱讀下面的發行說明以獲取更改摘要。

2022.1 版本為之前的 2021.4.2 LTS 版本提供了功能性錯誤修復和功能更改。 這個新版本為開發人員提供了新的性能增強、更多的深度學習模型、更多的設備可移植性和更高的推理性能,同時代碼更改更少。

注意:這是一個標準版本,適用於喜歡最新功能和領先性能的開發人員。標準版本將繼續每年提供三到四次。還提供長期支持 (LTS) 版本。每年都會發布一個新的 LTS 版本,支持 2 年(1 年的錯誤修復,2 年的安全補丁)。閱讀 英特爾® 分發 OpenVINO™ 工具套件長期支持 (LTS) 政策 以獲取詳細信息。最新的 LTS 版本: 2020.x LTS 和 2021.x LTS。

- 更新,更清潔的 API:

- 引入了新的 OpenVINO API 2.0。API 將 OpenVINO 輸入/輸出與框架對齊。輸入和輸出張量使用原生框架佈局和元素類型。舊的推理引擎和 nGraph API 可用,但將在未來的版本中棄用。

- inference_engine、inference_engine_transformations、inferencengine_lp_transformations 和 ngraph 庫被合併到通用 openvino 庫中。其他庫已重命名。請 在所有 OpenVINO 組件中使用通用ov::命名空間。有關詳細信息,請參閱 如何使用 OpenVINO API v2.0 實現推理管道 。

- 模型優化器的 API 參數已減少,以最大限度地降低複雜性。ONNX 模型的模型轉換性能得到了顯著提升。

- 強烈建議遷移到 API 2.0,因為它已經具有附加功能,並且此列表將在以後擴展。API 2.0 支持以下附加功能列表:

-

使用動態形狀。該功能對於神經語言處理 (NLP) 模型、超分辨率模型和其他接受動態輸入形狀的模型的最佳性能非常有用。 注意:與在相同輸入張量大小上使用靜態形狀配置的模型相比,使用動態形狀編譯的模型可能會降低性能並消耗更多內存。建議設置上限以重塑動態形狀的模型或將輸入分成幾個部分。

-

模型 預處理,為推理模型增加預處理操作,充分佔用加速器,釋放CPU資源。

-

-

閱讀 遷移指南 以遷移到新的 API 2.0。

- 便攜性和性能:

-

新的 AUTO 插件可以根據模型要求自我發現可用的系統推理能力,因此應用程序不再需要提前了解其計算環境。

-

OpenVINO™ 性能提示是在考慮到便攜性的 情況下配置性能的新方法 。提示以正確的方式“反轉”配置方向:與其將應用程序需求映射到低級性能設置,並保留關聯的應用程序邏輯來分別配置每個可能的設備,其想法是表達一個目標場景使用單個配置鍵,讓 設備 進行自我配置作為響應。由於每個 OpenVINO™ 設備都支持這些提示,因此這是一個完全便攜且面向未來的解決方案。

-

通過代碼提示的自動批處理功能 會根據 XPU 和可用內存自動縮放批處理大小。

-

-

更廣泛的模型支持:

-

借助 CPU 上的動態輸入形狀 功能,OpenVINO 將能夠在單個模型中適應多個輸入維度,從而提供更完整的 NLP 支持。在未來的 dot 版本中預計會在其他 XPU 上支持動態形狀。

-

-

專注於 NLP 和新類別、異常檢測的新模型 ,並支持選擇 PaddlePaddle 模型的轉換和推理:

-

預訓練模型: 異常分割專注於工業檢測,使語音去噪可訓練,以及語音識別和語音合成的更新

-

組合Demo: 降噪+語音識別+問答+翻譯+文字轉語音

-

公共模型: 專注於 NLP ContextNet、Speech-Transformer、HiFi-GAN、Glow-TTS、FastSpeech2 和 Wav2Vec

-

-

以第 12 代智能英特爾® 酷睿™“Alder Lake”為設計理念。 支持混合架構,為 CPU 和集成 GPU 上的高性能推理提供增強功能

系統要求

免責聲明。 某些硬件(包括但不限於 GPU 和 GNA)需要安裝特定的驅動程序才能正常工作。驅動程序可能需要更新您的操作系統,包括 Linux 內核,請參閱他們的文檔。操作系統更新應由用戶處理,而不是 OpenVINO 安裝的一部分。

Intel® CPU 處理器與相應的操作系統

支持英特爾® SSE4.2 的英特爾® 凌動* 處理器

Intel® Pentium® 處理器 N4200/5、N3350/5、N3450/5 與 Intel® HD Graphics

第 6 至第 11 代 Intel® Core™ 處理器

英特爾® 至強® 可擴展處理器(原 Skylake)

第二代 Intel® Xeon® 可擴展處理器(以前稱為 Cascade Lake)

第三代英特爾® 至強® 可擴展處理器(以前稱為 Cooper Lake 和 Ice Lake)

操作系統:

- Ubuntu* 18.04 長期支持 (LTS),64 位 - 支持但有限制*

- Ubuntu* 20.04 長期支持 (LTS),64 位

- Windows* 10、64 位

- macOS* 10.15,64 位

- 紅帽企業 Linux* 8、64 位

具有相應操作系統的英特爾® 處理器顯卡(GEN 顯卡)

英特爾® 核芯顯卡

英特爾® 超高清顯卡

英特爾® Iris® Pro 顯卡

英特爾® Iris® Xe 顯卡

英特爾® Iris® Xe Max 顯卡

操作系統:

- Ubuntu* 18.04 長期支持 (LTS),64 位 - 支持但有限制*

- Ubuntu* 20.04 長期支持 (LTS),64 位

- Windows* 10、64 位

- 紅帽企業 Linux* 8、64 位

- Yocto * 3.0, 64 位

筆記:

- 此安裝需要未包含在英特爾® Distribution of OpenVINO™ 工具包中的驅動程序。

- 英特爾® 至強® 處理器需要支持處理器圖形的芯片組。並非所有處理器都包含處理器圖形。有關您的處理器的信息,請參閱 產品規格 。

- 推薦 的 OpenCL™ 驅動程序 版本:Ubuntu* 18.04 的 21.38、Ubuntu* 20.04 的 21.48 和 Red Hat Enterprise Linux* 8 的 21.49

英特爾® 高斯和神經加速器

操作系統:

- Ubuntu* 18.04 長期支持 (LTS),64 位 - 支持但有限制*

- Ubuntu* 20.04 長期支持 (LTS),64 位

- Windows* 10、64 位

具有相應操作系統的 VPU 處理器

採用英特爾® Movidius™ 視覺處理單元 (VPU) 和相應操作系統的英特爾® 視覺加速器設計

操作系統:

- Ubuntu* 18.04 長期支持 (LTS),64 位(Linux 內核 5.2 及更低版本)- 支持但有限制*

- Ubuntu* 20.04 長期支持 (LTS),64 位

- Windows* 10、64 位

帶有相應操作系統的英特爾® Movidius™ 神經計算棒和英特爾® 神經計算棒 2

操作系統:

- Ubuntu* 18.04 長期支持 (LTS),64 位 - 支持但有限制*

- Ubuntu* 20.04 長期支持 (LTS),64 位

- Windows* 10、64 位

- Raspbian*(僅限目標)

帶有 Intel® Movidius™ Myriad™ X C0 VPU、MYDX x 1 和相應操作系統的 AI 邊緣計算板

操作系統:

- Windows* 10、64 位

注意: 受限制支持* - Ubuntu 18.04 已轉換為 受限制支持。Ubuntu 18.0x 不支持從 2022.1 及更高版本發布的新 Intel 硬件。從 2022.1(Q1'22)開始,推薦的新操作系統版本為 Ubuntu 20.04。此信息是 OpenVINO 2021.x 發行說明中棄用消息的一部分。

操作系統和開發者的環境要求:

- Linux * 操作系統

- 帶有 Linux 內核 5.3 的 Ubuntu 18.04

- 帶有 Linux 內核 5.4 的 Ubuntu 20.04

- 帶有 Linux 內核 5.4 的 RHEL 8

- Ice Lake、Tiger Lake、Alder Lake 需要更高版本的內核才能獲得 GPU 功能

- Linux* 操作系統構建環境需要以下組件:

- GNU 編譯器集合 (GCC)* 7.5 (Ubuntu 18)、8.4 (RHEL 8) 9.3 (Ubuntu 20)

- CMake * 3.10 或更高版本

- 蟒蛇* 3.6-3.9

- 開放CV 4.5

- Windows* 10 版本 20H2

- Windows* 操作系統構建環境需要以下組件:

- 微軟 Visual Studio* 2019

- CMake 3.14 或更高版本

- 蟒蛇* 3.6-3.9

- 開放CV 4.5

- 英特爾® 核芯顯卡驅動程序。僅 GPU 需要。

- Windows* 操作系統構建環境需要以下組件:

- macOS* 10.15

- macOS 構建環境需要以下組件:

- Xcode * 10.3

- 開放CV 4.5

- 蟒蛇 3.6 -3.9

- CMake 3.13 或更高版本

- macOS 構建環境需要以下組件:

- 深度學習框架版本:

- TensorFlow* 1.15、2.5

- MxNet* 1.7.0

- ONNX* 1.8.1

OpenVINO™ 開發工具 (pip install openvino-dev)

- 注意: 獲取 OpenVINO™ 開發工具 的新默認和推薦方法是通過“ pip install openvino-dev ”安裝它們。包含的組件列表及其更改:

-

模型優化器

- API 2.0 變化:

- 引入了新的 IR v11 版本。新的 IR v11 版本將輸入和輸出表示與原生框架格式對齊,無需轉換即可將框架模型傳遞給 OpenVINO。仍支持舊版 OpenVINO API,以保持與現有 OpenVINO 用例的向後兼容性。兩種 API 都接受針對不同用例的 v10 和 v11 IR。OpenVINO 2.0 API 使用舊版約定來支持 IR v10,此外,如果開發人員使用 IR v11 模型調用舊版 API,它將在運行時通過舊版行為路徑進行處理。

- 模型佈局、數據類型以及參數和結果節點的順序現在與原始框架對齊。由於數據類型現在已對齊,這意味著模型優化器可以在其中生成具有 I64 和 FP64 的 IR,以防此類類型存在於原始模型中。

- 引入了新的 CLI 參數來指定模型優化器的模型輸入和輸出源/目標佈局:

--source_layout--target_layout和--layout - 閱讀 遷移指南 以遷移到新的 API 2.0。

- 常見變化:

- 切換到將模型轉換為 FP16 數據類型的新方法。如果

--data_type=FP16指定,則只有常量將存儲在 FP16 數據類型中,而輸入和輸出將保持與原始模型中相同的數據類型。 - 將模型優化器命名空間與其他 OpenVINO 工具對齊。現在所有模型優化器類、函數定義和聲明都應該作為 openvino.tools.mo導入。

- 要改善開箱即用 (OOB) 體驗:

- 實現了自動檢測

--disable_nhwc_to_nchw。 --input_shape現在是可選的,以防輸入等級不是動態的,並且可以在模型轉換時省略,這將產生具有未定義維度的 IR

- 實現了自動檢測

- 新的剪枝變換,負責從卷積層和矩陣乘法層中移除零權重,現在可用,並且可以應用於模型,通過 神經網絡壓縮框架 (NNCF)中的過濾器剪枝算法進行了優化。應將新的 CLI 參數 --transform=Pruning 提供給 MO 以啟用 Pruning 轉換。

- 刪除了以前不推薦使用的選項

--generate_deprecated_IR_V7和--legacy_ir_generation - 與 Caffe 相關的已棄用 MO 選項

–-mean_file--mean_file_offsets

- 切換到將模型轉換為 FP16 數據類型的新方法。如果

- ONNX*:

- 模型優化器默認切換到 ONNX 前端,這將顯著減少模型轉換時間

- 對 Gather 和 Slice 運算符的擴展支持(負索引、非恆定軸)。

- 擴展支持具有 2 個輸出的 MaxPool:值和索引。

- 使用動態形狀時對多個運算符的擴展支持:

- 恆定形狀

- 恩蘇姆

- 擴張

- 環形

- 非最大抑制

- 非零

- 軟墊

- 範圍

- 減和

- 重塑

- 調整大小

- 瓦

- 上採樣

- 添加了對以下操作的支持:

- 如果

- 量化運算符:

- 轉換整數,

- MatMulInteger

- QLinearConv

- QLinearMatMul

- 支持隨機數生成器:

- 隨機正常

- RandomNormalLike

- 隨機制服

- RandomUniformLike

- TensorFlow*:

- 擴展了對包含 SparseSegmentMean 操作並刪除 I64 輸入限制的 Wide & Deep 系列模型的支持

-

添加了對以下操作的支持:

- 隨機制服

-

如果

-

添加了對以下操作的支持,但有限制:

-

空張量列表

-

TensorListPushBack

-

- MXNet*:

-

添加了對以下操作的支持:

- 批處理點

- 層規範

- contrib.arange_like

- contrib.div_sqrt_dim

-

-

訓練後優化工具

- POT 源代碼已作為 OpenVINO 存儲庫中的子文件夾移至 GitHub。許可證已更改為 Apache-2.0。現在允許對 POT 進行外部貢獻。

- 通過 POT CLI 添加了對 GNA 的 INT8 量化支持。

- 適用於 GNA 的 AccuracyAware (AA) 量化方法 (INT16+INT8)。

- Concat 操作的統一尺度。

- 改進了適用於較新英特爾處理器的基於 Transformer 的模型的 INT8 量化方案。

- 內存使用優化,以減少 POT 在量化期間使用的內存。

- 支持新的 OpenVINO 2.0 API。

- 添加了對 IRv11 的支持。自 OpenVINO 2022.1 起,POT 不支持 IRv10,如果使用較舊的 IR 版本,則會引發異常。

- 刪除了對 TunableQuantization 算法的支持。2021.4 LTS 是 POT 中支持此算法的最終版本。

- 擴展模型覆蓋範圍:啟用 +70 個 INT8 模型。

- (實驗)Ranger 算法用於安全關鍵情況下的模型保護。

- 基準工具 允許您在支持的設備上估計同步和異步模式的深度學習推理性能。

- Accuracy Checker 是一種深度學習準確性驗證工具,可讓您針對流行的數據集收集準確性指標。該工具的主要優點是配置的靈活性和一組支持的數據集、預處理、後處理和指標。

- Annotation Converter 是一個實用程序,可以準備數據集以使用 Accuracy Checker 進行評估。

- 模型下載器和其他開放模型動物園工具

- Model Downloader 將 Open Model Zoo 預訓練的 Intel 和公共模型加載到指定文件夾

-

Model Converter - 具有 Open Model Zoo 公共模型的預定義配置的 MO 啟動器

- Model Quantizer - 具有 Open Model Zoo 公共模型的預定義配置的 POT 啟動器

- Model Info Dumper - 打印基本模型信息

- 數據下載器 - 將模型相關數據加載到指定文件夾

OpenVINO™(推理引擎)運行時

-

常見變化

-

引入了新的 OpenVINO API 2.0。API 將 OpenVINO 輸入/輸出與框架對齊。輸入和輸出張量使用原生框架佈局和元素類型。舊的推理引擎和 nGraph API 可用,但將在未來的版本中棄用。

-

inference_engine、inference_engine_transformations、inferencengine_lp_transformations 和 ngraph 庫合併到通用 openvino 庫中。其他庫已重命名。 在所有 OpenVINO 組件中使用通用 ov ::命名空間。請閱讀 如何使用 OpenVINO API v2.0 實現推理管道以 了解詳細信息。

-

模型優化器的 API 參數已減少,以最大限度地降低複雜性。ONNX 模型的模型轉換性能得到了顯著提升。

-

強烈建議遷移到 API 2.0,因為它已經具有附加功能,並且此列表將在以後擴展。API 2.0 支持以下附加功能列表:

- 使用動態形狀。該功能對於神經語言處理 (NLP) 模型、超分辨率模型和其他接受動態輸入形狀的模型的最佳性能非常有用。 注意:與在相同輸入張量大小上使用靜態形狀配置的模型相比,使用動態形狀編譯的模型可能會降低性能並消耗更多內存。建議設置上限以重塑動態形狀的模型或將輸入分成幾個部分。

-

模型 預處理,為推理模型增加預處理操作,充分佔用加速器,釋放CPU資源。

-

閱讀 遷移指南 以遷移到新的 API 2.0。

-

-

圖形表示

-

引入 opset8。最新的 opset 包含 此頁面上列出的新操作。並非所有 OpenVINO™ 工具包插件都支持這些操作。

-

-

OpenVINO Python API

-

注意: 為 Python 開發人員獲取 OpenVINO™ 運行時的新默認和推薦方法 是通過“ pip install openvino ”安裝它。

-

引入了基於 OpenVINO 2.0 API 的新 OpenVINO Python API。舊的 nGraph Python API 和推理引擎 Python API 可用,但將在未來版本中棄用。

-

作為 Python API 2.0 的一部分,發布了附加功能:

-

更改了 Python API 包的佈局。現在通用 API 是 openvino.runtime、openvino.preprocess 的一部分。

-

添加了 AsyncInferQueue 是為了使用異步 API 進行簡單高效的工作。

-

改變了創建 InferRequests 的方式——現在它與 C++ API 保持一致。

-

對 infer 方法中輸入參數的擴展支持。所有同步推斷方法都返回結果。

-

CompiledModel 對象可以在沒有顯式調用 Core 的情況下創建。

-

調用 CompiledModel (__call__) 隱藏了一個 InferRequest 的創建,並提供了一種運行單個同步推理的簡單方法。

-

對張量的擴展支持:

-

通過與數組共享內存或將數據複製到張量直接從 Numpy 數組創建張量對象。

-

創建一個具有指定數據類型和形狀的空張量對象,並用數據填充它。

-

-

-

-

自動裝置

-

新推出的 AUTO 設備,可在 CPU、GPU 和 VPU 之間自動選擇執行設備進行推理(如果可用)。

-

如果選擇 GPU/VPU 進行推理,則通過在將網絡加載到選定設備時首先使用 CPU 插件運行推理,然後熱交換到選定設備,改進了第一次推理延遲。

-

支持延遲和吞吐量等性能提示,無需提供設備配置詳細信息。

-

-

英特爾® CPU

-

添加了對具有動態形狀的模型的支持。該功能包括對外部和內部動態類型的完整功能覆蓋,並針對 NLP 和實例分割場景進行性能微調。

-

實現了模型緩存支持。該功能可以顯著改善首次推理延遲。

-

改進了非視覺用例的推理性能,主要關注基於 Bert 的模型。

-

改進了最適合音頻用例的一維模型的推理性能。

-

通過減少非計算開銷,提高了極輕量模型的推理性能。

-

添加了為吞吐量性能提示計算最佳流數的功能。

-

引入了 Snippets 組件和 Snippets CPU 後端。Snippets 在目標硬件上提供自動 JIT 代碼生成功能,並使用通用編譯器優化技術來實現最佳性能。這可以在廣泛的模型集上實現最佳推理性能可達性。

-

其他更多詳細訊息, 請造訪Release Notes for Intel® Distribution of OpenVINO™ Toolkit 2022