DL Workbench 全称是"Deep Learning Workbench", 是Openvino 2019 R3版本新增的功能, 目前是预览版本。主要功能是对模型进行分析和调优。

DL Workbench是一个基于图形化界面的环境,可以让用户在Intel的各种硬件(包括CPU、GPU、VPU)上对深度学习的模型和数据集进行可视化的性能仿真。

仿真完成后,会给出完整的性能测试报告,大大方便了我们对于模型的评估。另外,用户可以通过DL Workbench把模型的某些Layout的精度从FP32量化到8bit,从而在CPU上跑模型算法能够得到更好的速度,而经过fine-turn后,精度并没有很大的影响。

准备:

1. 安装好Openvino 2019 R3

2. 安装好Docker CE 18.06.1 或以上版本

3. Google Chrome *72或以上版本

安装DL Workbench

1. 安装Docker CE

参考docker的官方文档:https://docs.docker.com/install/

2. 执行命令, 进行安装DL Workbench,因为要从网络上下载安装档案,所以花费时间比较长,我们耐心等待一下。

3. 退出或者重启后再次启动DL Workbench:

DL Workbench的使用

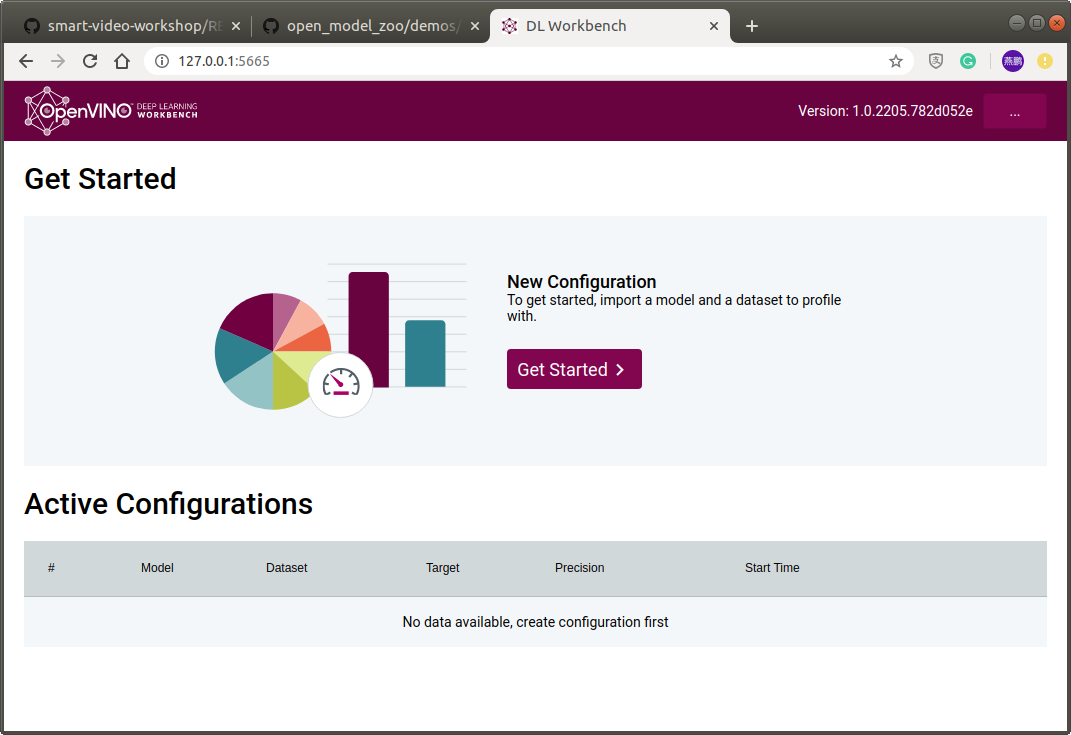

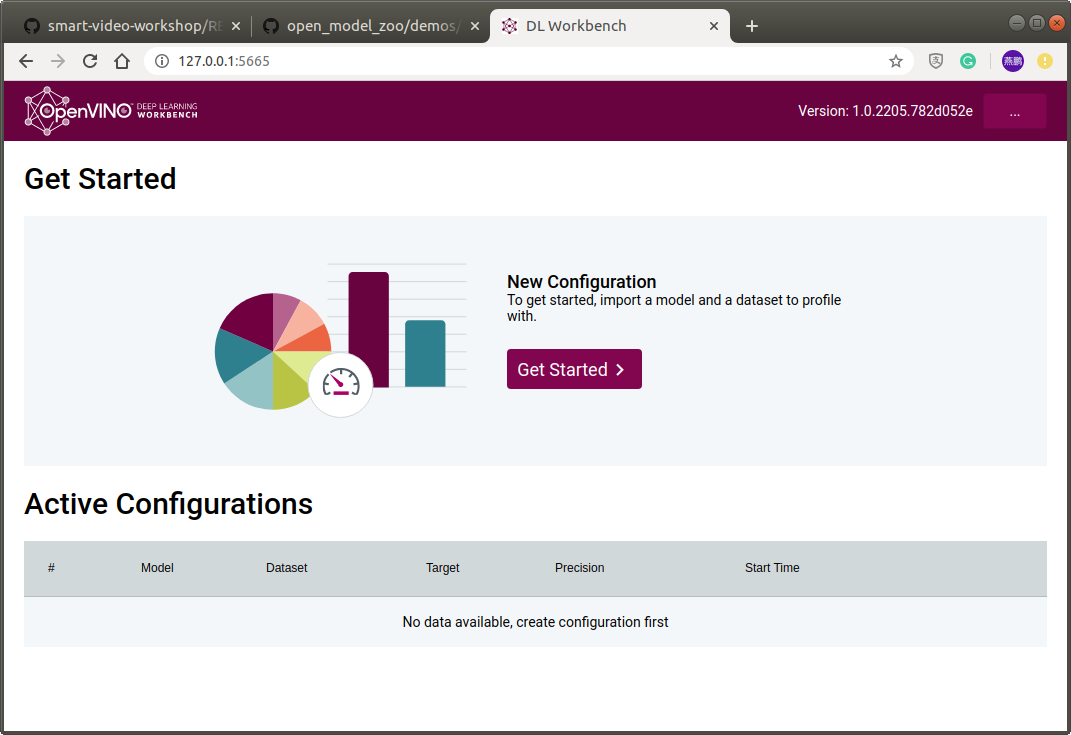

1. 在浏览器里输入http://127.0.0.1:5665, 我们可以看到DL Workbench的启动界面

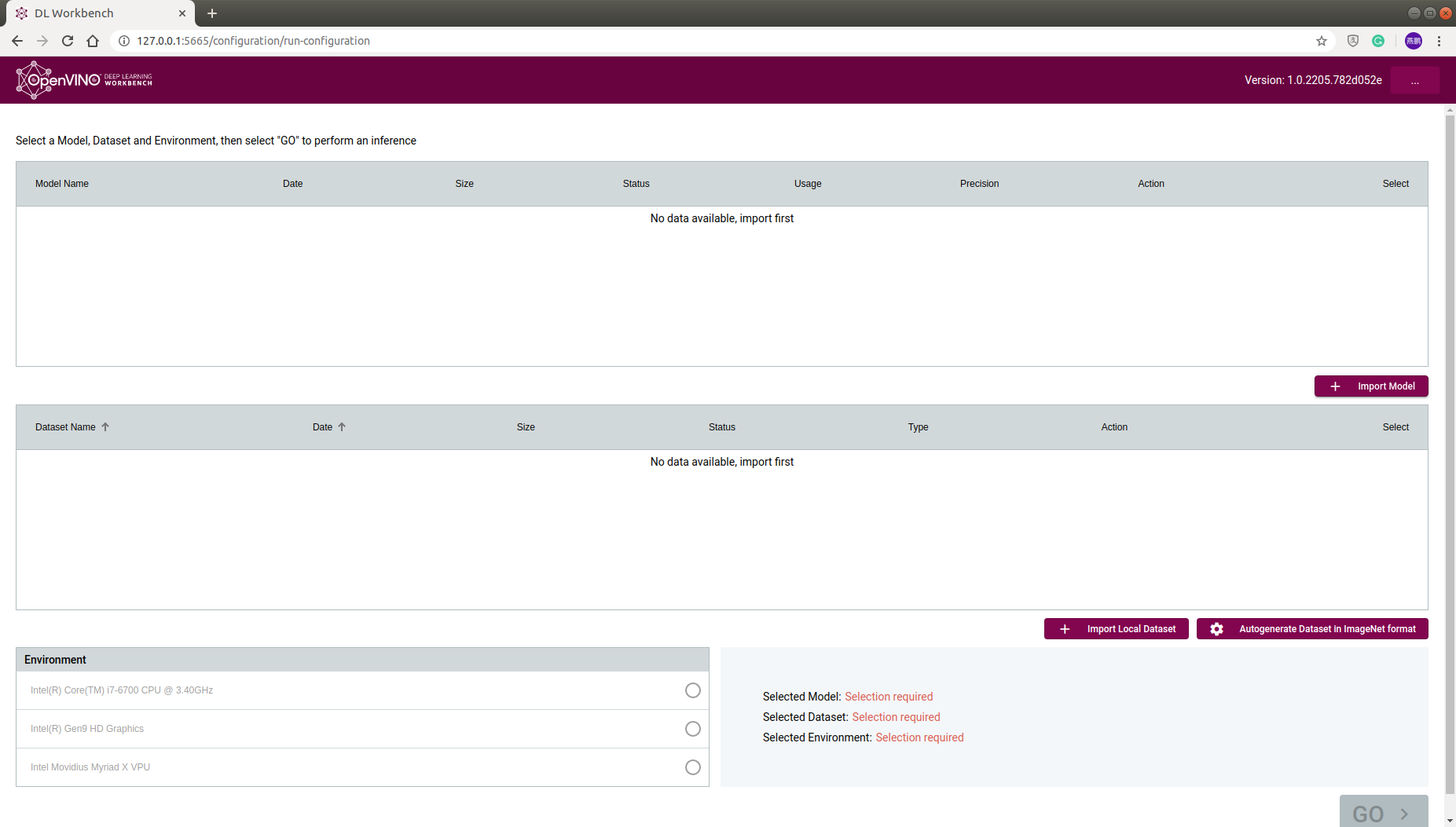

2. 点击Get started,进入Configration界面

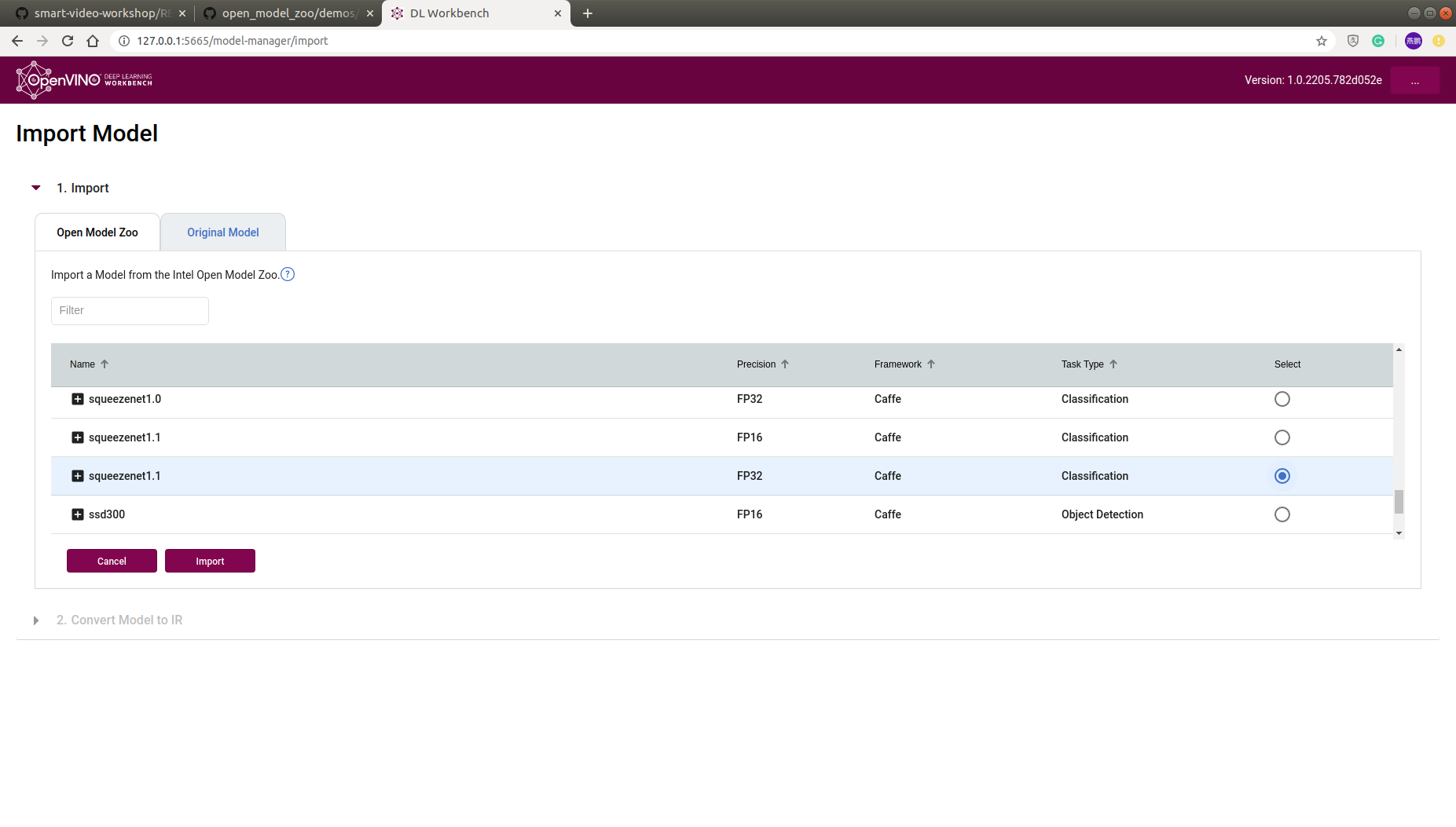

3. 选择模型,可以选择从本地导入,也可以直接选择从Open Model Zoo里导入,这里我们选择squeezenet1.1,点击"Import Models":

DL Workbench是一个基于图形化界面的环境,可以让用户在Intel的各种硬件(包括CPU、GPU、VPU)上对深度学习的模型和数据集进行可视化的性能仿真。

仿真完成后,会给出完整的性能测试报告,大大方便了我们对于模型的评估。另外,用户可以通过DL Workbench把模型的某些Layout的精度从FP32量化到8bit,从而在CPU上跑模型算法能够得到更好的速度,而经过fine-turn后,精度并没有很大的影响。

准备:

1. 安装好Openvino 2019 R3

2. 安装好Docker CE 18.06.1 或以上版本

3. Google Chrome *72或以上版本

安装DL Workbench

1. 安装Docker CE

参考docker的官方文档:https://docs.docker.com/install/

2. 执行命令, 进行安装DL Workbench,因为要从网络上下载安装档案,所以花费时间比较长,我们耐心等待一下。

docker run -p 127.0.0.1:5665:5665 --name workbench --privileged -v /dev/bus/usb:/dev/bus/usb -v /dev/dri:/dev/dri -e PORT=5665 -it openvino/workbench:latest

安装完成后,会自动运行DL Workbench的docker服务3. 退出或者重启后再次启动DL Workbench:

docker start workbench

DL Workbench的使用

1. 在浏览器里输入http://127.0.0.1:5665, 我们可以看到DL Workbench的启动界面

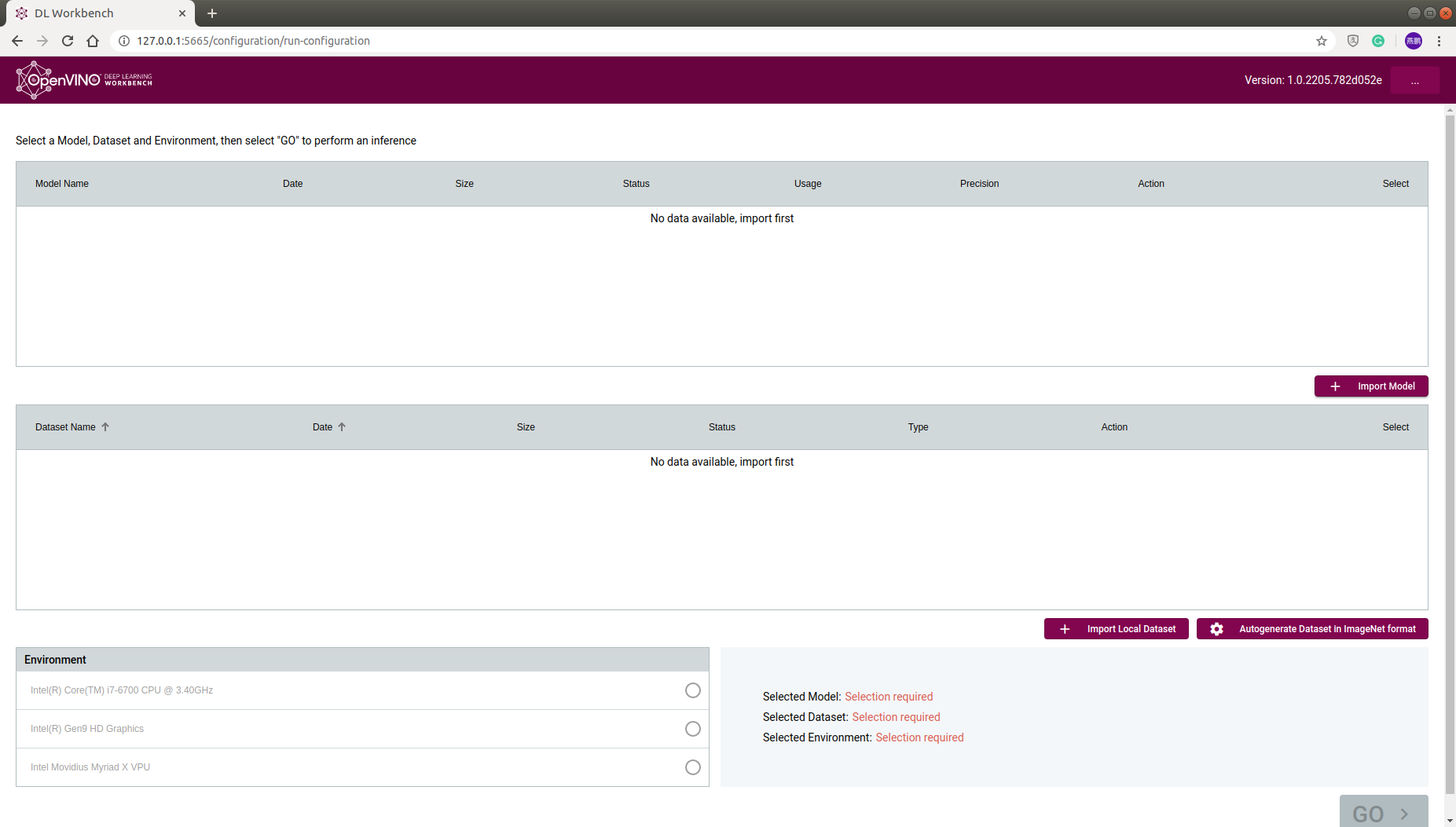

2. 点击Get started,进入Configration界面

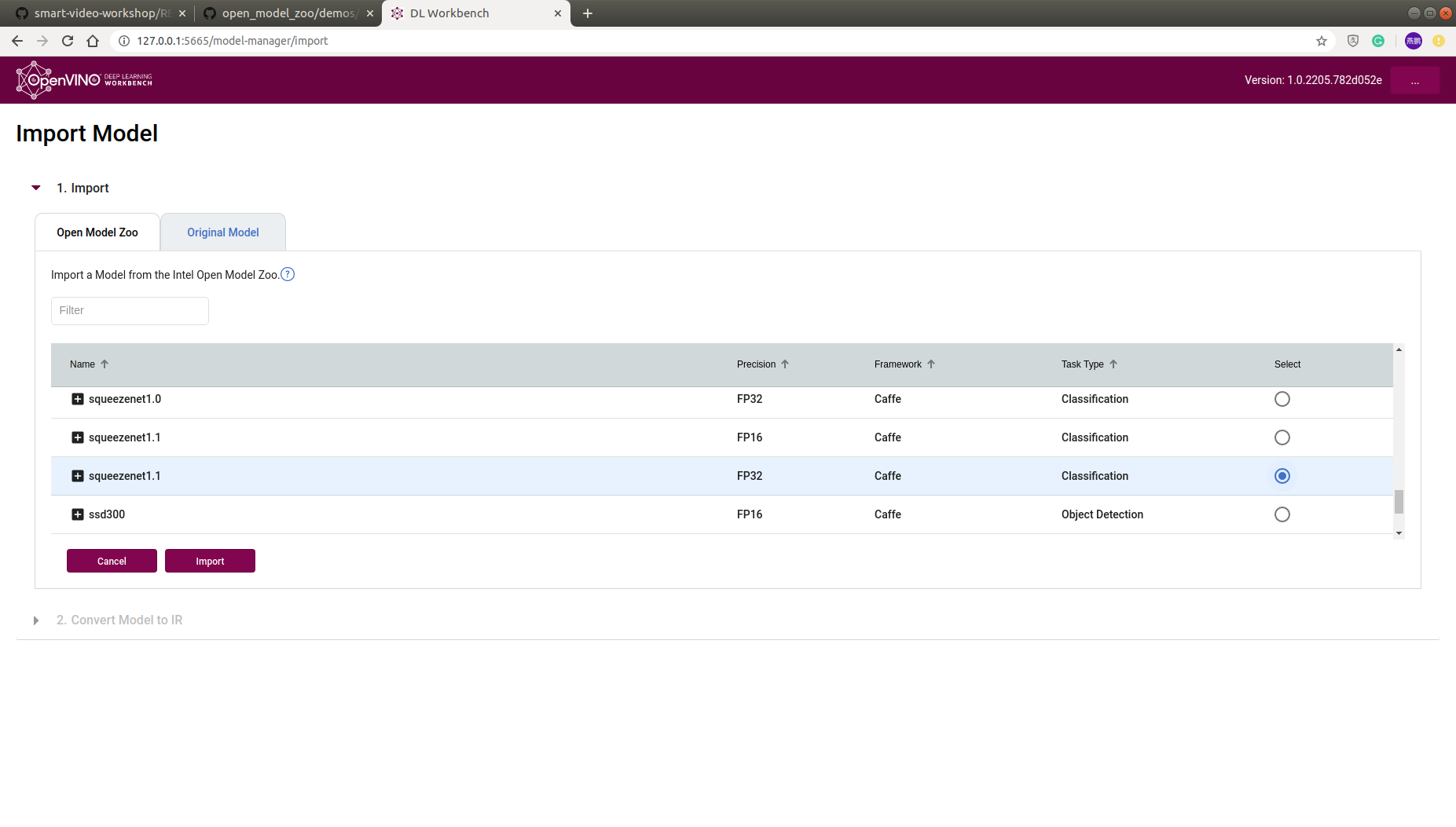

3. 选择模型,可以选择从本地导入,也可以直接选择从Open Model Zoo里导入,这里我们选择squeezenet1.1,点击"Import Models":

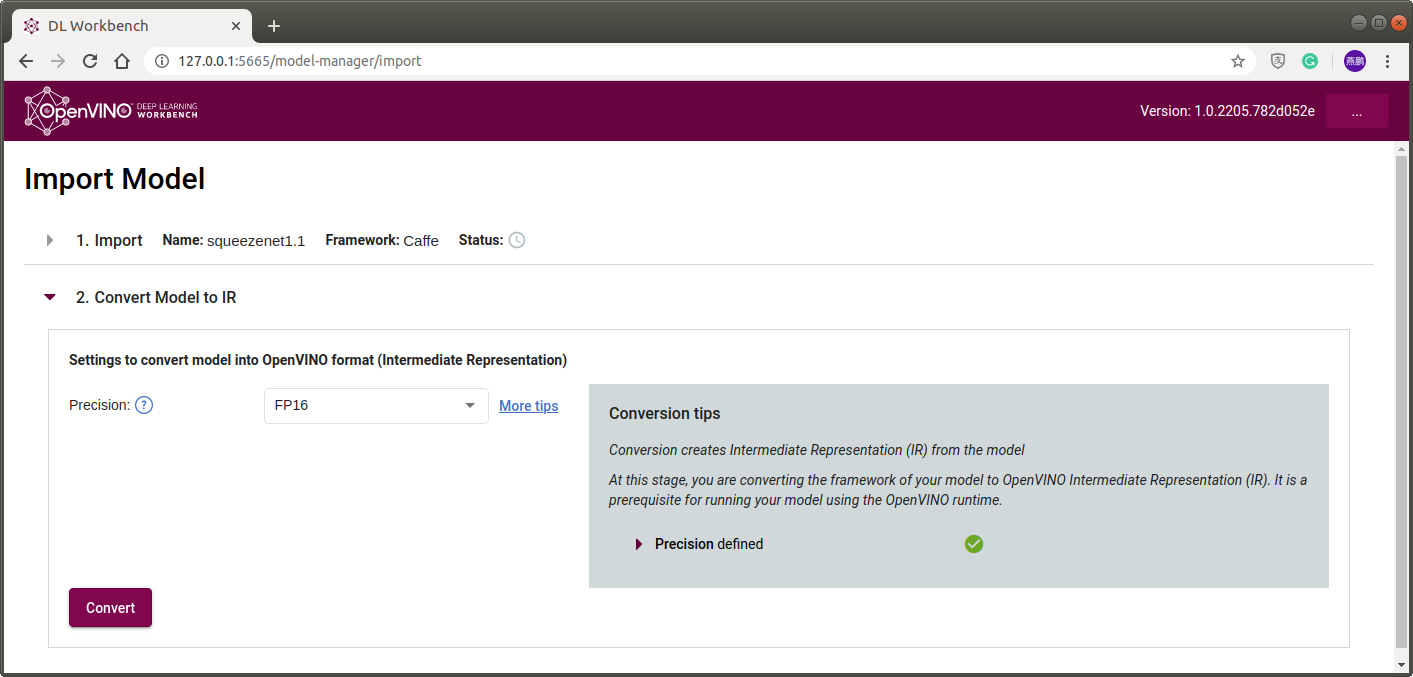

4. 接下来会把squeezenet1.1从Open Model Zoo里面下下来,等待status变成对勾,选择FP32,点击"Convert",进行模型转换:

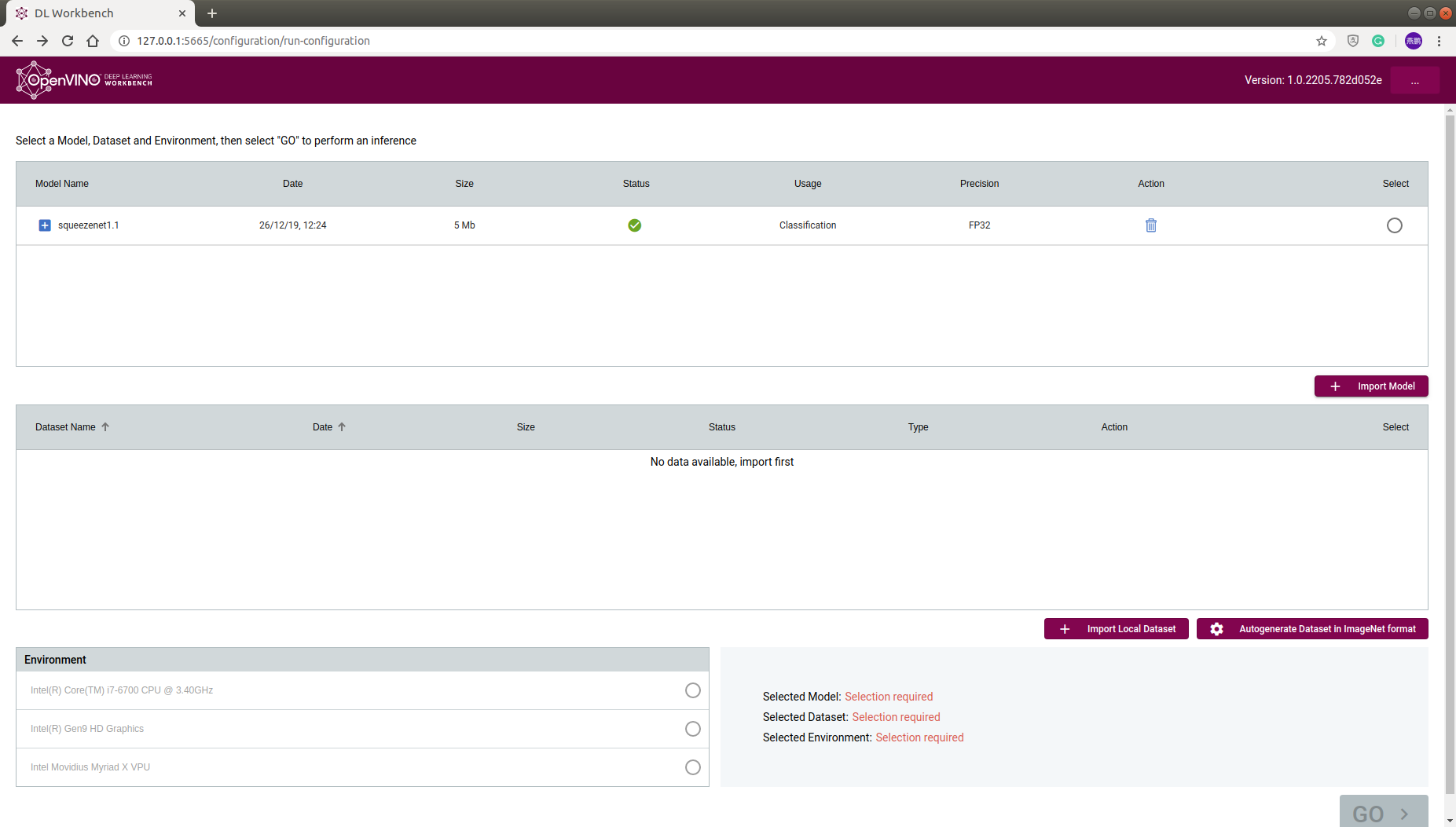

5. 转换成功后Status会变成"√",

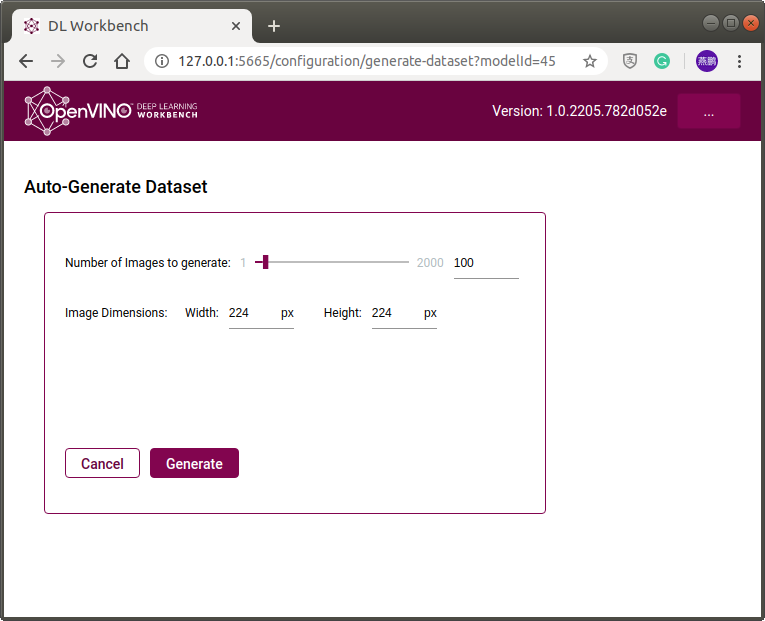

6. Generate Dataset: 选择"Autogenerate Dataset in ImageNet format", 我们选择100张, 224x224大小, 等待status变成"√"

数据集收集完成:

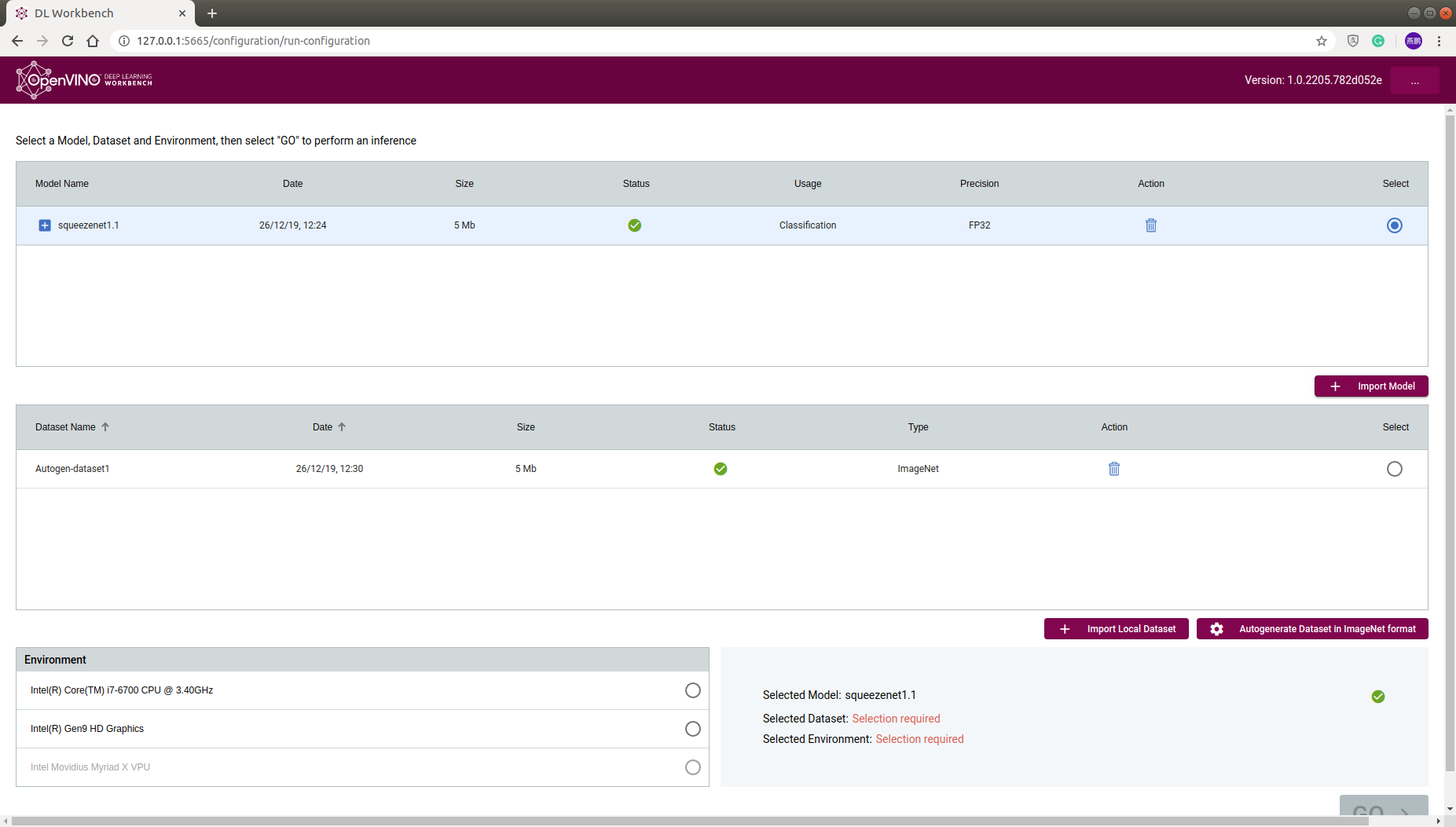

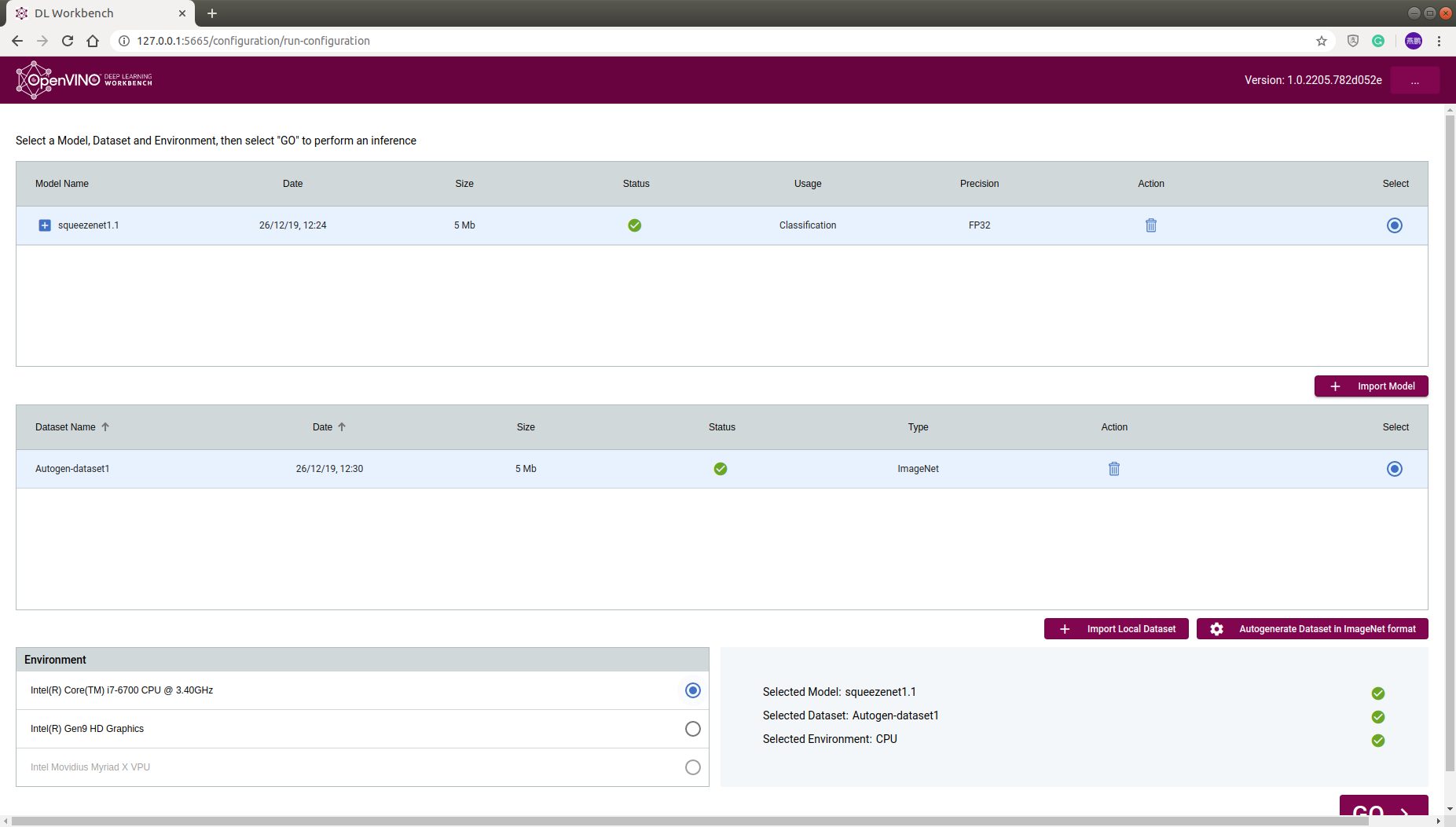

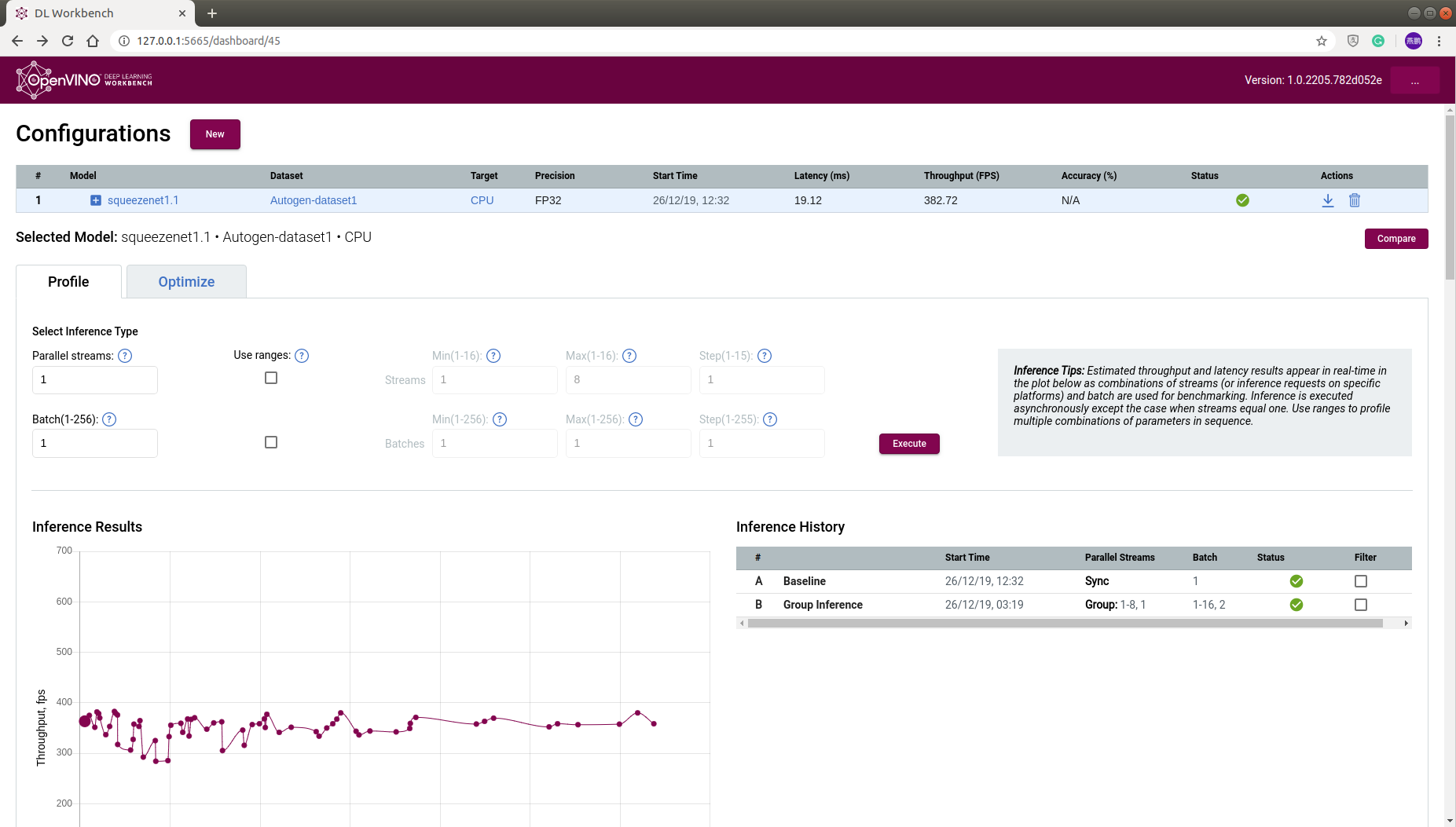

7. 选择我们刚刚下载的模型,数据集,还有CPU平台,点击"GO",开始Inference

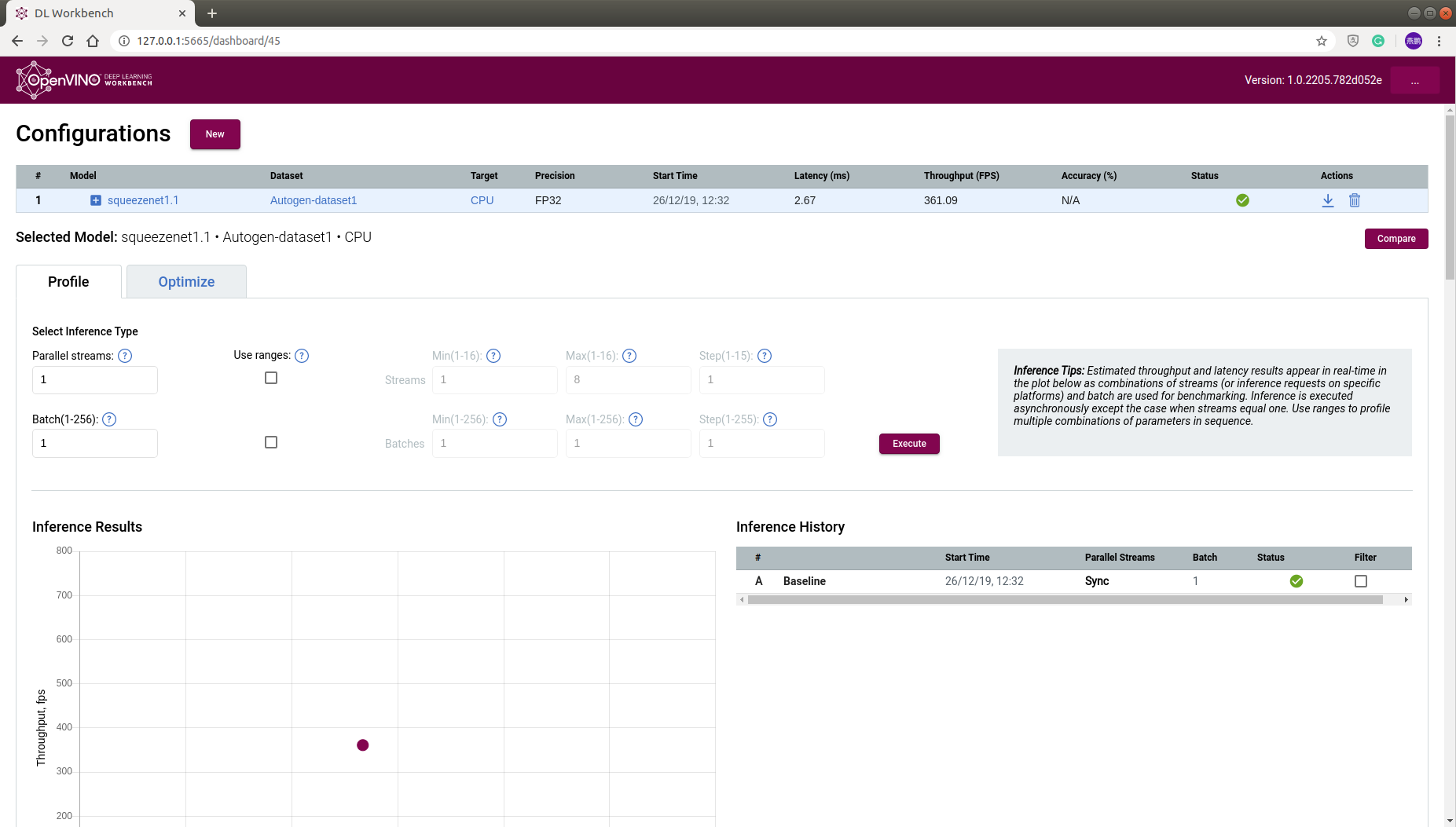

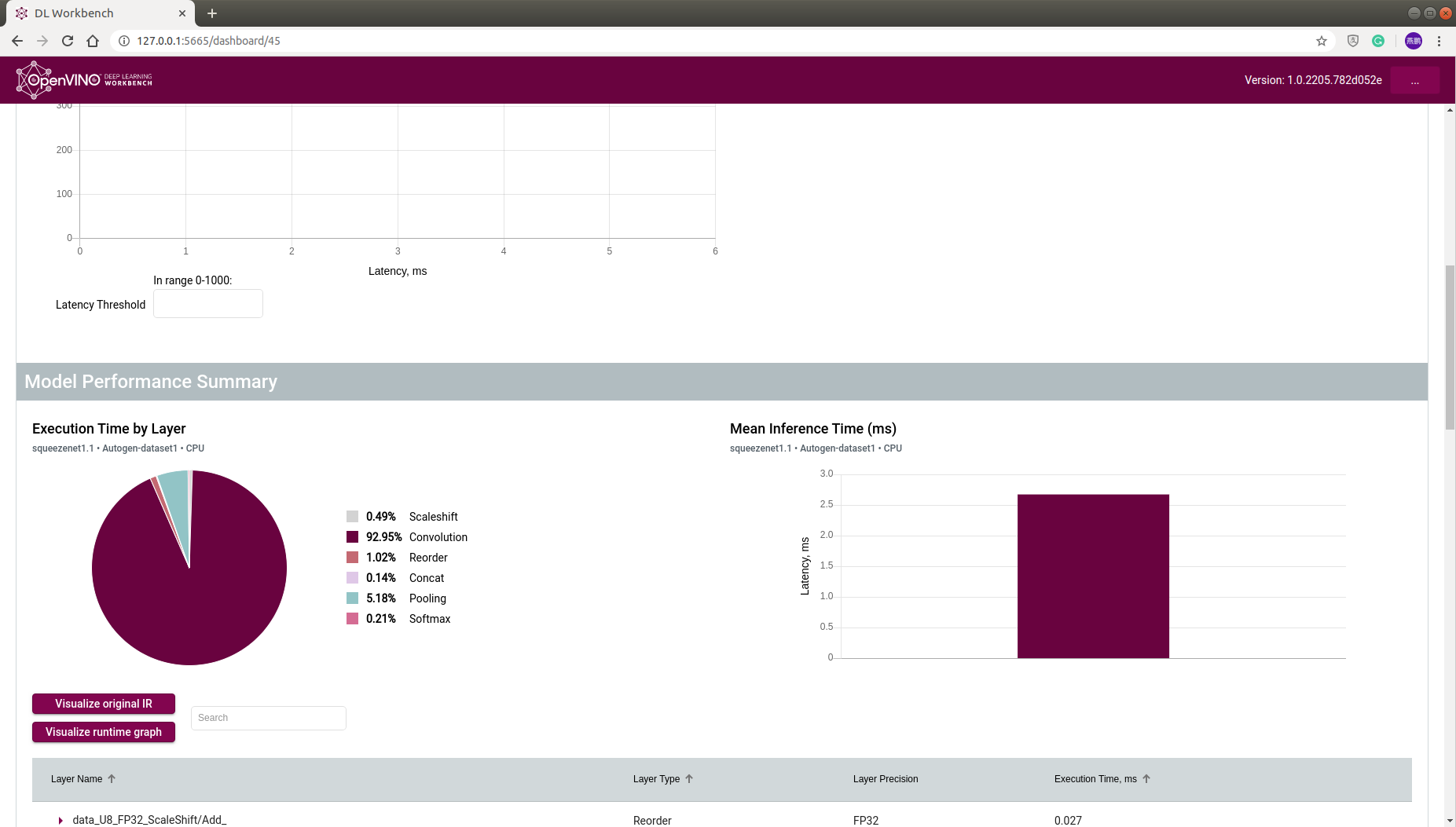

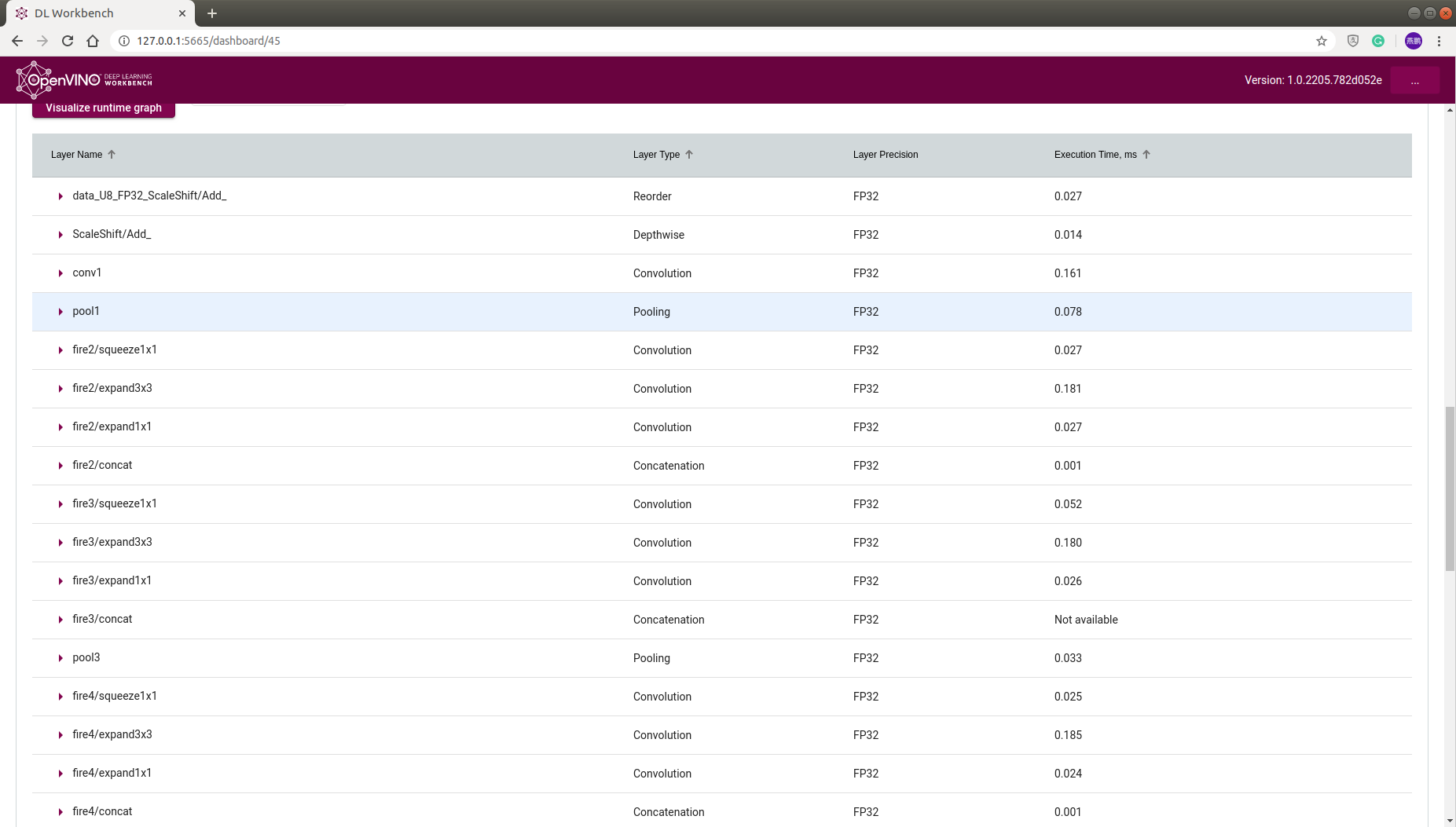

8. Inference结束后,我们就可以看到最终模型性能分析的结果

参数:

结果1:

结果2:

9. 可以设置不同的"Parallel streams"和"Batch",找到最适合的参数

评论