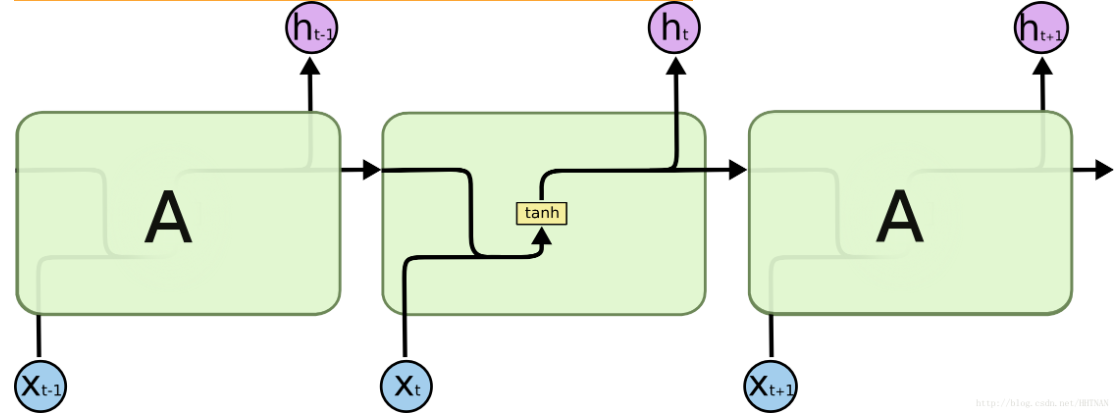

在上一章提到RNN有梯度消失、梯度爆炸的問題傳統RNN在實際中很難處理長期依賴。而LSTM(Long Short Term Memory)則繞開了這些問題依然可以從語料中學習到長期依賴關係。傳統RNN如圖1每一步的隱藏單元只是執行一個簡單的tanh或ReLU操作。

圖1 傳統RNN

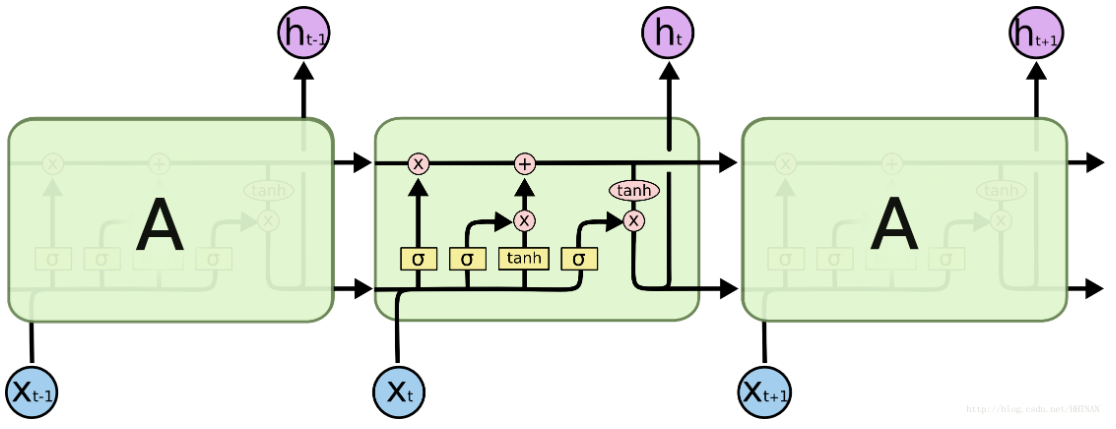

LSTM每個迴圈的模組內又有4層結構:3個sigmoid層,1個tanh層

圖2 LSTM RNN

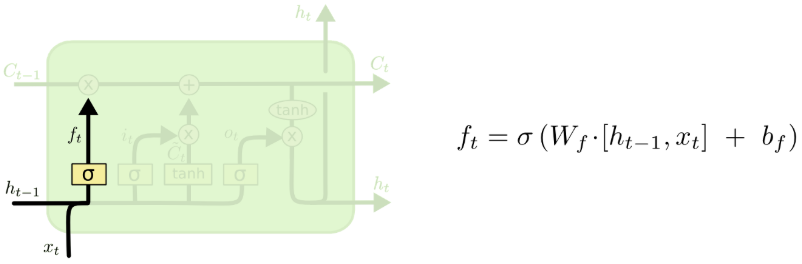

所以第一步是,決定哪些資訊要忘掉,透過這個黃色的邏輯函數我們可以決定從上一層的輸出帶進來的資訊,以及這一層新增加的資訊,有多少比例要被忘掉,不被帶進下一層。

第一層是個忘記層,決定細胞狀態中丟棄什麼資訊。把ht−1ht−1和xtxt拼接起來,傳給一個sigmoid函式,該函式輸出0到1之間的值,這個值乘到細胞狀態Ct−1Ct−1上去。sigmoid函式的輸出值直接決定了狀態資訊保留多少。

圖3 LSTM 第一層

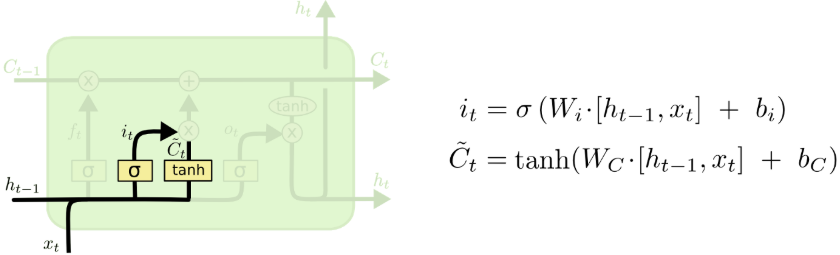

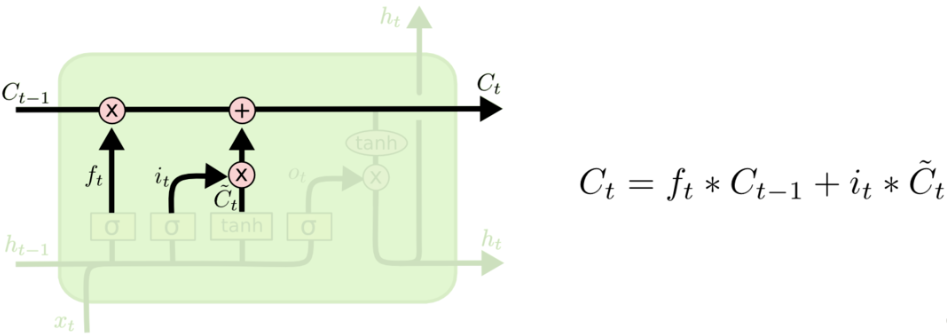

接下來本步應該把哪些資訊新加到細胞狀態中呢?這裡又包含2層:一個tanh層用來產生更新值的候選項C~tC~t,tanh的輸出在[-1,1]上,說明細胞狀態在某些維度上需要加強,在某些維度上需要減弱;還有一個sigmoid層(輸入門層),它的輸出值要乘到tanh層的輸出上,起到一個縮放的作用,極端情況下sigmoid輸出0說明相應維度上的細胞狀態不需要更新。

圖4 LSTM RNN 第二層

圖5 LSTM RNN 輸出層

最後該決定輸出什麼了。輸出值跟細胞狀態有關,把CtCt輸給一個tanh函式得到輸出值的候選項。候選項中的哪些部分最終會被輸出由一個sigmoid層來決定。在那個預測下一個詞的例子中,如果細胞狀態告訴我們當前代詞是第三人稱,那我們就可以預測下一詞可能是一個第三人稱的動詞。以上,就是標準的 LSTMs 在單元中每一步驟做的事情。透過這樣看似簡單的幾個步驟,已經在許多應用上都大幅改善 RNN 的效果。

評論