大語言模型能夠很好地理解使用者需求,在溝通和回應方面表現出色。然而,其能力主要集中在語言交流上。為了拓展其功能,目前已有如 workflow 和 agent 等框架可以實現多樣化的功能。我們利用這些框架,使邊緣端的資源和算力能夠為大模型服務,從而打造雲邊端一體化的應用場景。在本文中,我們將使用 LangChain 工具來實現一個 LLM(大語言模型)可以調用邊緣設備功能的 agent 框架。

LangChain 簡介:

在當前百模大戰的背景下,許多開發者希望搭建 AI 應用,但常常面臨以下痛點:更換模型需要重寫調用程式碼、多步驟任務邏輯複雜、私有數據無法對接、對話內容容易丟失等。而 LangChain 的出現,恰好為這些問題提供了一站式解決方案。作為開源的大模型應用開發框架,LangChain 已成為 AI 開發者的必備工具。它的模組化設計讓開發過程如同搭積木一般簡單;支援全模型相容,切換模型無需修改程式碼;具備數據處理與工具調用能力,突破大模型的功能邊界;智能流程編排可輕鬆完成複雜任務;其全端生態系統從開發到部署一站式覆蓋。

實現框架的步驟

我們將使用 LangChain 將 LLM 和 MCP 連接起來,完整實現邊緣設備和邊緣計算接入大模型的業務框架。具體步驟如下(邊緣端的 MCP 使用的是 synaptics 的 Astra SL1640 設備,MCP 實現方法請參考上一篇博文):

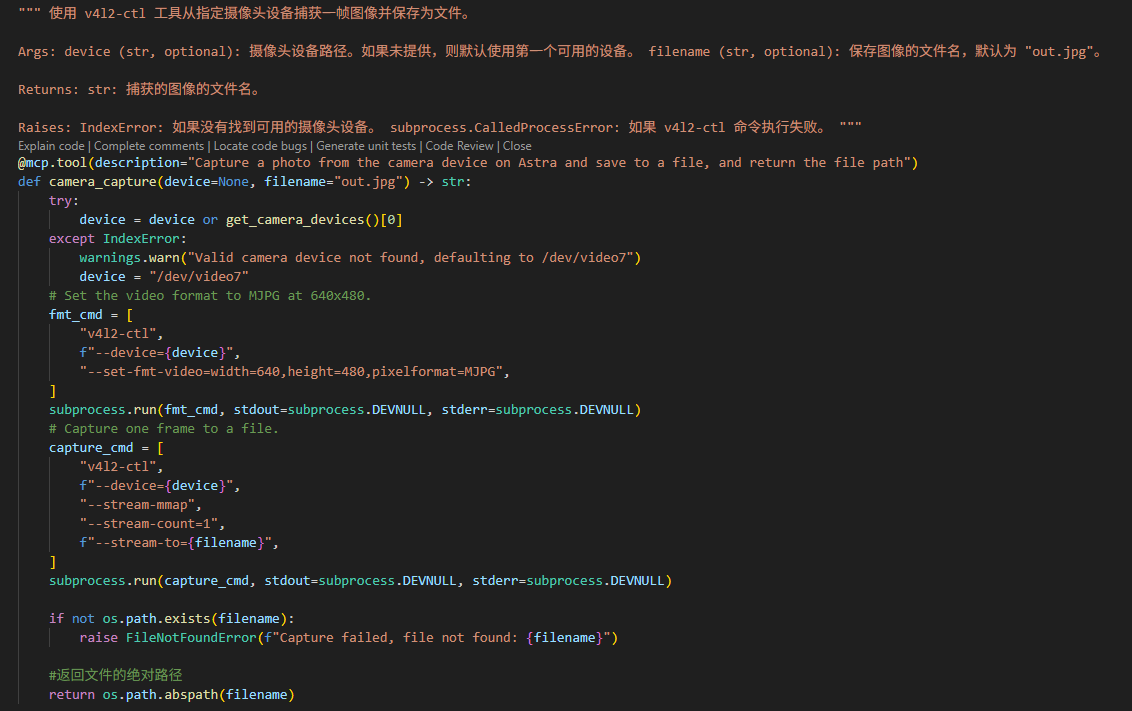

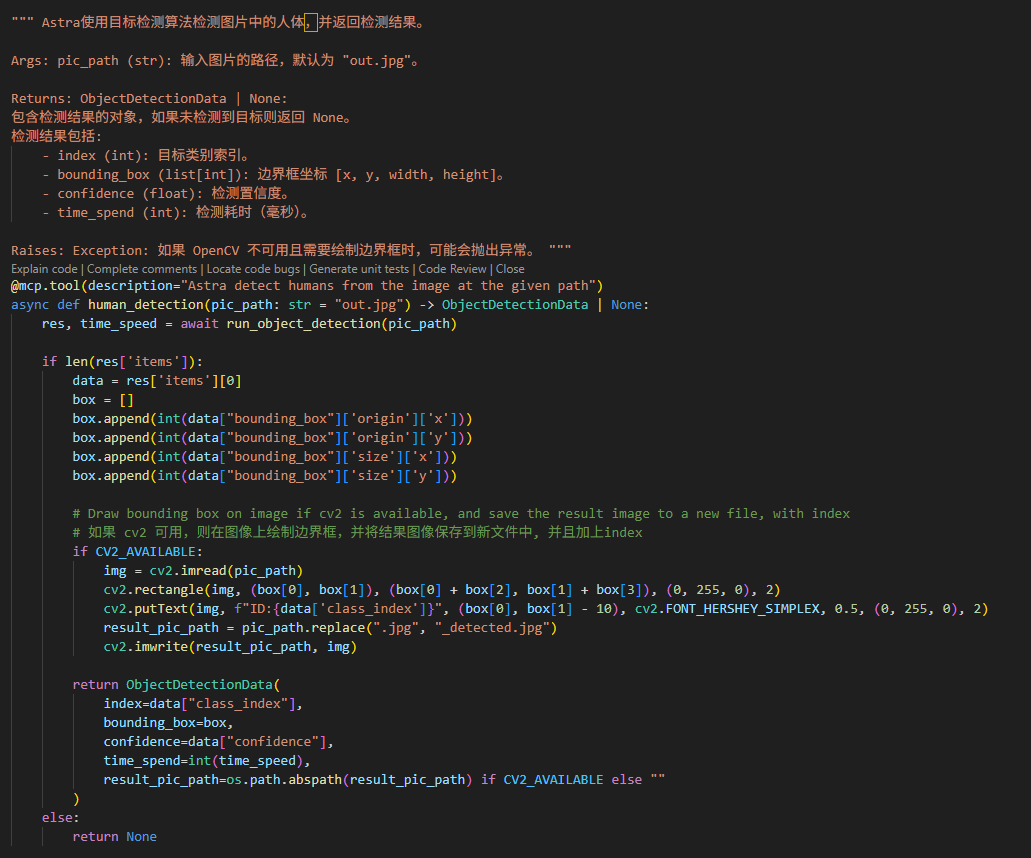

1. 啟動 MCP Server:

根據上一篇部落格文章的介紹,首先執行 Astra 的 MCP Server。邊緣端的功能(工具)定義為兩個主要功能:使用相機拍照以及辨識照片中的人物。

2. 撰寫 LangChain 程式:

接下來編寫一個 LangChain 程式以使用 MCP。該程式可以運行在應用主體上,例如 PC、手機、中控設備,甚至 Astra 平台本身。LLM 可以選擇使用本地模型或雲端 API。

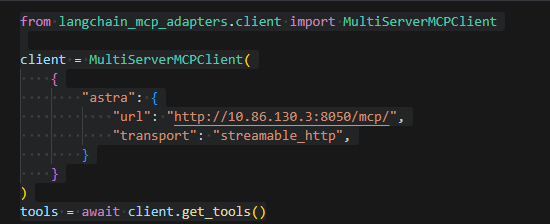

註冊 MCP 資訊:

使用 LangChain 的 Python 套件,將 MCP 的資訊註冊到程式中

這裡的IP地址就是Astra的

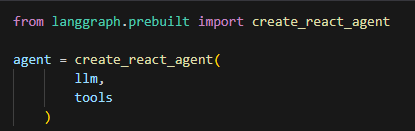

建立代理人

創建一個 Agent,將 LLM 和 MCP 綁定起來

3. 使用 AI 自動調用 MCP:

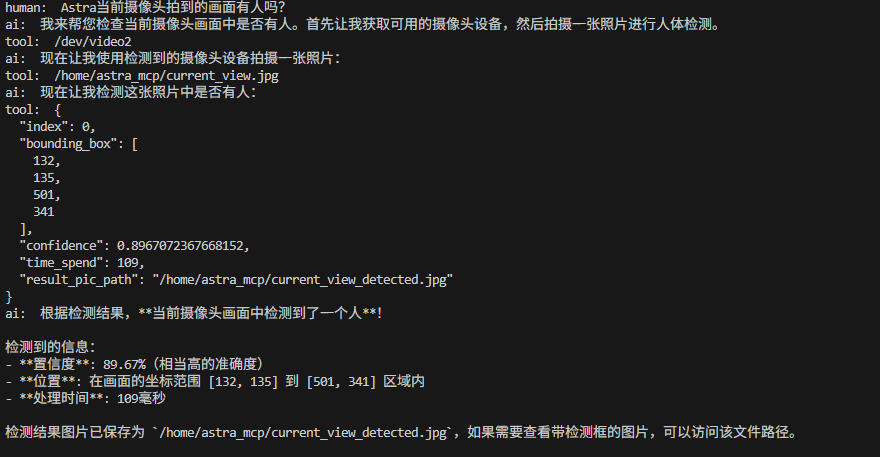

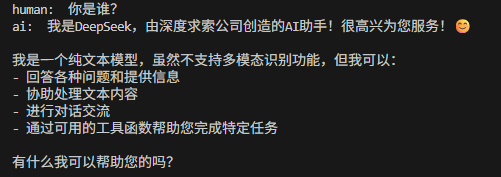

在完成上述步驟後,使用者可以像平常一樣使用 AI。系統會根據需求自動判斷是否需要調用 MCP。

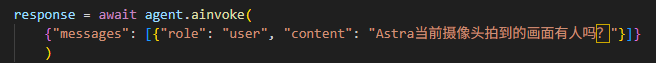

呼叫 MCP 的情況:

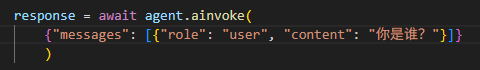

未呼叫 MCP 的情況:

透過這一框架,MCP 只需準確描述並實現自身功能,LLM 就能根據使用者需求獲取相應資源。即使大模型本身不具備圖像識別或高精度判斷能力,也可以透過邊緣設備實現這些功能,同時在一定程度上保護資料安全。

以上是本期部落格文章的全部內容,如有疑問請在文章下方留言,或者聯繫我們,我們會盡量安排處理喔(o´ω`o)و。感謝大家的瀏覽,我們下期再見。

常見問題 1:LangChain 適合初學者嗎?

A1:LangChain 提供了模組化設計和豐富的文件支援,非常適合初學者快速上手開發 AI 應用。

常見問題 2:LangChain 支援哪些模型?

A2:LangChain 支援多種大型語言模型,包括 OpenAI 的 GPT 系列、Anthropic 的 Claude、Google 的 PaLM 等,同時也支援在地化模型。

FAQ 3:如何保護資料隱私?

A3:透過邊緣運算,資料可以在本地處理,減少上傳到雲端的需求,從而有效保護使用者隱私。

常見問題 4:LangChain 是否支援多語言?

A4:是的,LangChain 支援多語言處理,能夠根據使用者需求實現多語言對話和任務。

FAQ 5:邊緣運算的優勢是什麼?

A5:邊緣運算能夠降低資料傳輸延遲、減少頻寬需求,同時提升資料安全性和即時處理能力。

常見問題 6:如何部署 LangChain 應用程式?

A6:LangChain 應用可以部署在多種平台上,包括雲端伺服器、當地設備、行動端等,具體部署方式取決於應用場景。

FAQ 6:LangChain 是否開源?

A6:是的,LangChain 是一個開源框架,開發者可以自由使用和擴展其功能。

評論