越複雜的神經網絡,越多的數據,我們需要在訓練神經網絡的過程上花費的時間也就越多。原因很簡單,就是因為計算量太大了。可是往往有時候為了解決複雜的問題,複雜的結構和大數據又是不能避免的,所以我們需要尋找一些方法,讓神經網絡快起來。

包括以下幾種方式:

- Stochastic Gradient Descent (SGD)

- Momentum

- AdaGrad

- RMSProp

- Adam

Stochastic Gradient Descent (SGD):

圖1 SGD

最基礎的方法就是SGD,想像紅色方塊是我們要訓練的DATA,如果用普通的訓練方法,就需要重複不斷的把整套數據放入神經網絡NN訓練,這樣消耗的計算資源會很大。換一種思路,如果把這些數據拆分成小批小批的,然後再分批不斷放入NN 中計算,這就是我們常說的SGD 的正確打開方式了。每次使用小批數據,雖然不能反映整體數據的情況,不過卻很大程度上加速了NN 的訓練過程,而且也不會丟失太多準確率。

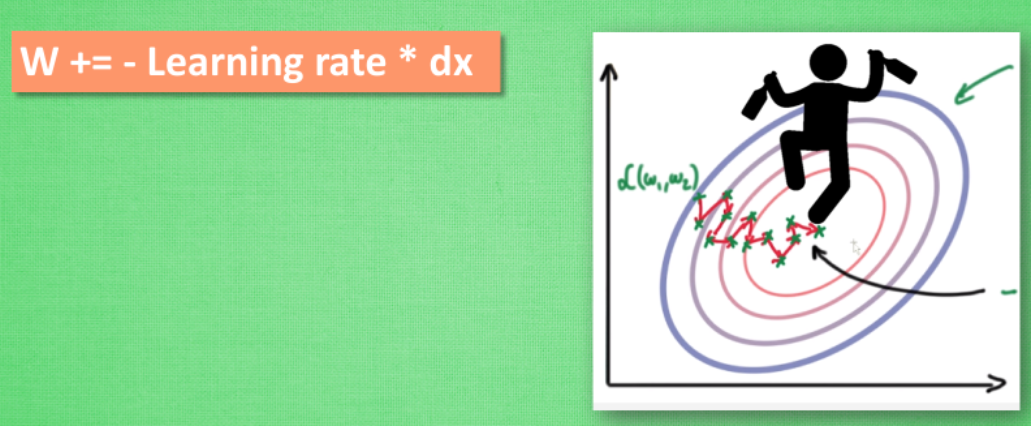

圖2 SGD更新參數

更新參數的方式 w+=-lr * dx (lr是學習率,dx 是校正值)

Momentum:

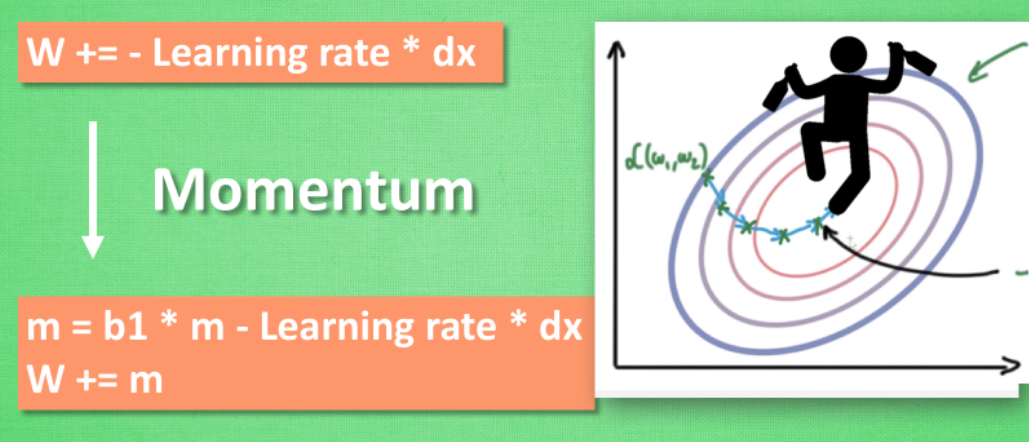

圖3 Momentum更新參數

Momentum考慮了不僅僅是當前步的學習效率,還考慮了上一步的學習趨勢,所以比SGD的方法更加快速。更新参数的方式 m=b1m-lrdx w+=m

AdaGred:

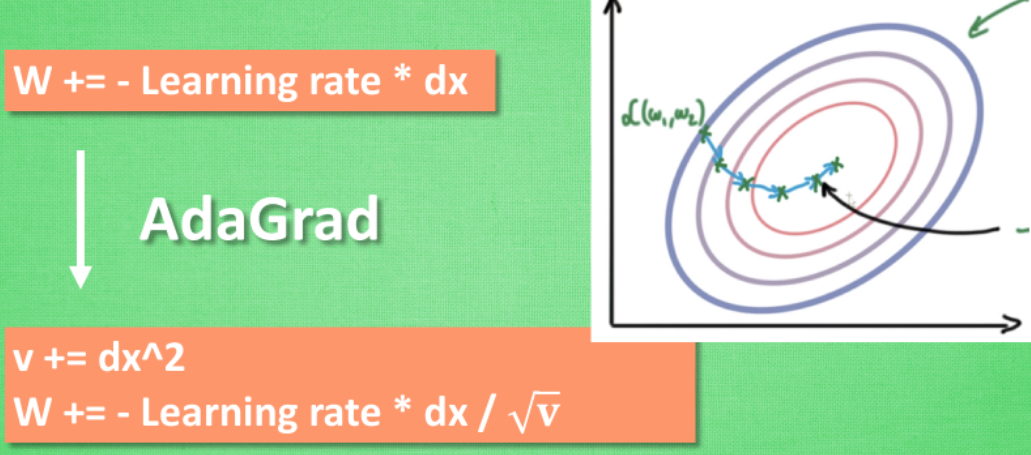

圖4 AdaGrad 更新參數

這種方法是在學習率上面動手腳, 使得每一個參數更新都會有自己與眾不同的學習率, 他的作用和 momentum 類似。該方法自動地調整學習率的大小,該方法下的learning rate會根據歷史的梯度值動態地改變學習率的大小。它需要計算更新到該t輪,參數的歷史梯度的平方和。更新参数的方法 v+=dx^2 w+= -lr *dx/根号V 采用改变学习率的方式

RMSProp:

圖5 RMSProp更新參數

它是一種自適應學習率算法,它與AdamGrad方法的不同之處在於,它只計算更新到該t輪,參數的歷史梯度的平均值。這種方法是將 Momentum與AdaGrad部分相結合

更新参数的方法v=b1*v=(1-b1)*dx^2 w+=-lr*dx/根號V

Adam:

圖6 Adam更新參數

它也是一種自適應學習率調整算法,同時也是最廣泛的一種方法。它利用的是梯度的一階矩估計和二階矩估計。該方法調整的學習率較為平穩,且預估結果較為準確。這種方法是將momentum與AdaGrad 相結合

更新參數:

m=b1*m+(1-b1)*dx

v=b2*v+(1-b2)*dx^2

w+=-lr*m/根號v

以上是比較常見的加速神經網絡的訓練的方法

評論